Nvidia souhaite réduire les coûts de l’IA grâce à l’essor des modèles de « raisonnement »

Le PDG de Nvidia a déclaré que le fabricant de puces d’IA construisait de nouvelles puces selon un cycle d’un an

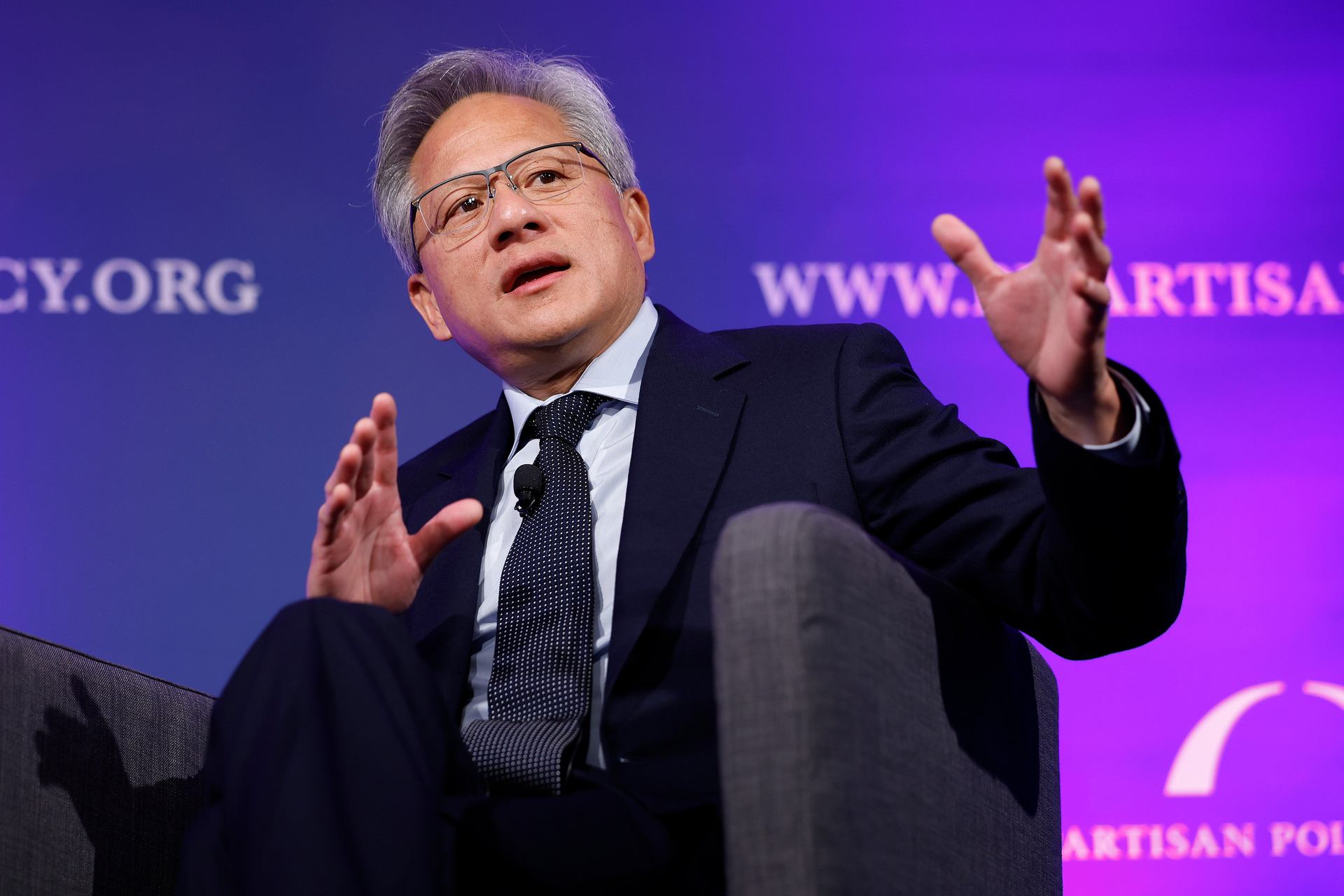

Nvidia (NVDA) les puces ont été l’un des moteurs du boom actuel de l’intelligence artificielle — et le fabricant de puces veut uniquement le faire aller plus rapidement , a déclaré le directeur général Jensen Huang.

Lectures Recommandées

Lors d’une apparition sur le Podcast Tech Unheard, Huang a été interrogé par l’animateur René Haas, directeur exécutif de la société de semi-conducteurs britannique Arm (BRAS), si le rythme de l’innovation en matière d’IA évolue « plus vite que vous ne l’imaginiez ».

Contenu Connexe

Huang a répondu : « Non », et a ajouté que Nvidia « essaie de le rendre plus rapide ».

« Nous sommes passés à un cycle d’un an », a déclaré Huang à propos de la production de nouvelles puces par l’entreprise. « Et la raison en est que la technologie a la possibilité d’évoluer rapidement. »

Nvidia conçoit « six ou sept nouvelles puces par système », a déclaré Huang, puis utilise la « co-conception pour réinventer l’ensemble du système » et invente d’autres technologies qui lui permettent d’améliorer les performances de deux ou trois fois tout en utilisant la même quantité d’énergie et le même coût chaque année.

« C’est une autre façon de réduire le coût de l’IA de deux ou trois fois par an », a déclaré Huang. « C’est bien plus rapide que la loi de Moore. »

Au cours des prochaines années, a déclaré Huang, Nvidia souhaite réduire le coût de l’IA dans un contexte d’essor de modèles encore plus complexes. Cette évolution est déjà en cours. En septembre, OpenAI a publié un nouvelle série de modèles d’IA « raisonnement » appelés o1, qui sont « conçus pour passer plus de temps à réfléchir avant de répondre », comme le font les humains.

À l’avenir, les services d’IA tels que ChatGPT d’OpenAI, que Huang dit utiliser tous les jours, « raisonneront de manière itérative sur la réponse » et pourront effectuer des centaines ou des milliers d’inférences avant de produire un résultat.

Ce niveau de traitement complexe nécessiterait une puissance de calcul nettement supérieure à celle des modèles actuels. Malgré les exigences accrues, Huang estime que le compromis en vaut la peine.

« La qualité de la réponse est bien meilleure », a déclaré Huang. « Nous voulons réduire les coûts afin de pouvoir proposer ce nouveau type d’inférence de raisonnement avec le même niveau de coût et de réactivité que par le passé. »

Mercredi, l’action de Nvidia remontait vers son record de clôture de 135 $ en juin. Les actions du fabricant de puces étaient en baisse de 0,27 % à la mi-journée, mais ont ouvert en hausse de près de 1 % à environ 134 $ par action.