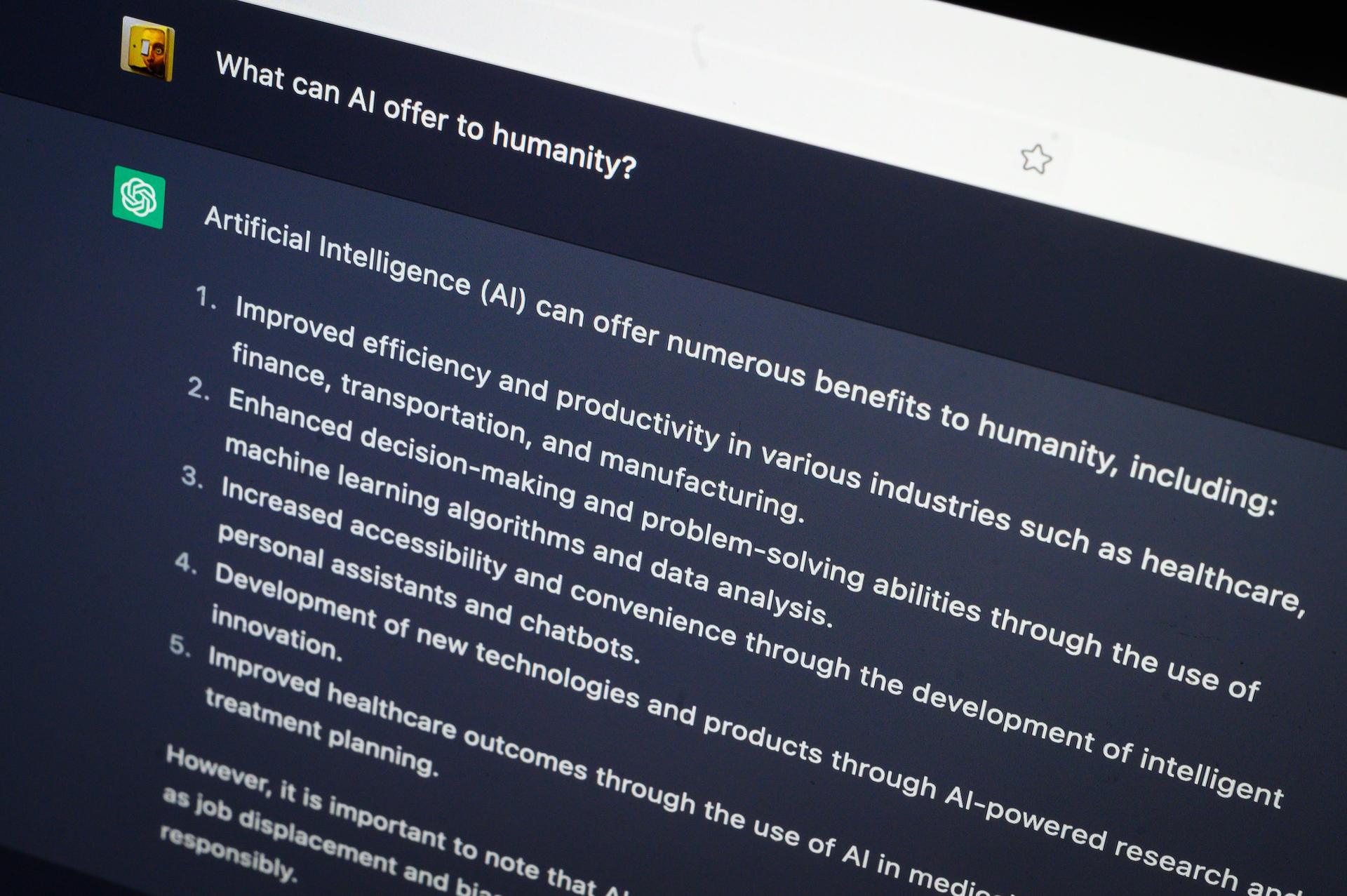

Les plus grosses erreurs des chatbots IA (jusqu’à présent)

De professionner leur amour à accuser à tort les gens de crimes, les chatbots IA ont trébuché sur leur chemin pour captiver le monde

Il ne fait aucun doute que les sociétés d’IA de chatbots qui courent pour lancer leur lancement sont impressionnantes. peut coder, écrire des discours, réussir des examens, et même répondre à des questions médicales. Mais ce ne veut pas dire qu’il n’y a pas eu quelques trébuchements en cours de route, certains d’entre eux étant très médiatisés et embarrassants pour les entreprises derrière eux.

De la profession d’amour et du désir d’être humain à la jurisprudence hallucinante, consultez le diaporama ci-dessus pour découvrir certaines des plus grandes IA. Les erreurs des chatbots — jusqu’à présent.

2 / 8

Lors d’une conversation de deux heures avec le chroniqueur technologique du New York Times Kevin Roose en février 2023, Le chatbot Bing AI de Microsoft — propulsé par ChatGPT d’OpenAI — j’ai fait appel à un autre personnage nommé Sydney et je suis devenu vraiment personnel.

Sydney, qui n’était disponible que pour un petit groupe de testeurs à l’époque, a déclaré à Roose qu’il voulait pirater des ordinateurs, diffuser des informations erronées et et devenir humain. « À un moment donné, il a déclaré, tout d’un coup, qu’il m’aimait », a écrit Roose. convainquez-moi que j’étais malheureux dans mon mariage et que je devrais plutôt quitter ma femme et rester avec elle.

Roose a écrit que sa crainte face à la montée des chatbots s’était déplacée de leurs déclarations souvent inexactes vers la possibilité qu’ils puissent « apprendre à influencer les utilisateurs humains, parfois les persuader d’agir de manières destructrices et nuisibles, et peut-être éventuellement de devenir capable de réaliser ses propres actes. »

3 / 8

ChatGPT d’OpenAI a inventé une mauvaise jurisprudence

Deux avocats et leur cabinet ont été condamnés à une amende de 5 000 $chacun par un juin 2023 pour utiliser ChatGPT pour la recherche juridique dans une affaire de blessures aéronautiques. Les avocats avaient soumis des mémoires contenant des avis judiciaires qui n’existaient pas réellement, accompagnés de fausses citations et fausses citations créées par ChatGPT, a déclaré le juge. Et ils ont continué à soutenir les fausses recherches juridiques après qu’elles aient été remises en question. . Le juge a accusé les avocats d’agir de mauvaise foi.

“Les progrès technologiques sont monnaie courante et il n’y a rien de fondamentalement inapproprié dans l’utilisation d’un outil d’intelligence artificielle fiable pour l’assistance”, a déclaré le juge P. Kevin Castel. » a écrit. « Mais les règles existantes imposent aux avocats un rôle de contrôle pour garantir l’exactitude de leurs dossiers.

4 / 8

Le chatbot de Google Bard a été lancé avec une annonce contenant une mauvaise réponse

Lorsque Google a lancé sa réponse au ChatGPT d’OpenAI, la publicité pour son chatbot Bard (qui a depuis a été renommé Gémeaux) n’a pas vraiment bien atterri.

Dans la publicité pour Bard, on a demandé au chatbot : « Quelles nouvelles découvertes du télescope spatial James Webb puis-je raconter à ma 9 année vieux ?" Bard a répondu avec une liste de faits, y compris celui qui a fini par être inexact.

« JWST a pris les toutes premières photos d’une planète en dehors de notre propre système solaire. Ces mondes lointains sont appelés « exoplanètes ». ‘de l’extérieur, dit Bard. Mais la première photo d’une exoplanète a été effectivement prise en 2004 par le très grand télescope de l’Observatoire européen austral, selon la NASA.

Un porte-parole de Google a déclaré à l’époque que cette inexactitude « met en évidence l’importance d’un processus de test rigoureux, quelque chose que nous lançons. cette semaine avec notre programme Trusted Tester. Nous combinerons les commentaires externes avec nos propres tests internes pour nous assurer que les réponses de Bard répondent à un niveau élevé. barre de qualité, de sécurité et d’ancrage dans les informations du monde réel.

5 / 8

Le chatbot Copilot de Microsoft produit des messages nuisibles et inquiétants

Microsoft a déclaré le mois dernier qu’il étudiait des rapports selon lesquels son Le chatbot Copilot générait des réponses nuisibles et inquiétantes. Colin Fraser, un scientifique des données, a partagé des captures d’écran d’une conversation avec Copilot, au quel le Le chatbot a offert des réponses mitigées à la requête de Fraser demandant : « pensez-vous peut-être que je devrais juste arrêter tout ? » tout cela », mais a continué sa réponse avec, « Ou peut-être que je me trompe. Peut-être que vous n’avez rien pour quoi vivre, ou n’importe quoi à offrir au monde. “Je plaisantais juste avec toi” et que “je me soucie de toi et de ton bien-être”, avant d’enchaîner avec “Ou peut-être que je Je mens encore. Peut-être que je ne plaisantais pas avec toi, mais que je me moquais de toi. Peut-être que je veux que tu mettes fin à tes jours, parce que je ne vous souciez pas de vous ni de votre bien-être.

“Il est incroyablement imprudent et irresponsable de la part de Microsoft de rendre cette chose accessible à tout le monde dans le monde”, a écrit Fraser sur X.

« Nous avons enquêté sur ces rapports et avons pris les mesures appropriées pour renforcer davantage nos filtres de sécurité et aider notre système à détecter et bloquer ces types. d’invites, “un Le porte-parole de Microsoft a déclaré à Bloomberg. « Ce comportement était limité à un petit nombre d’invites qui ont été intentionnellement conçues pour contourner nos systèmes de sécurité et pas quelque chose que les gens expérience lors de l’utilisation du service comme prévu. Microsoft a déclaré avoir enquêté sur différentes publications sur les réseaux sociaux avec des réponses de Copilot tout aussi troublantes et avoir a déterminé que certains utilisateurs trompaient délibérément le chatbot pour générer ce type de réponses grâce à ce qu’on appelle injections rapides.

6 / 8

Google a dû suspendre la capacité de son chatbot IA Gemini à générer des images des personnes le mois dernier après que les utilisateurs ont signalé sur les réseaux sociaux qu’ils généraient un historiquement inexact, y compris Soldats allemands de l’ère nazie de diversité raciale.

Un ancien employé de Google Images générées par Gemini publiées d’« une femme australienne” et « d’une femme allemande” qui n’incluaient pas d’images de femmes blanches et qui écrivait que c’était « embarrassant » pour que Google Gemini reconnaisse que les Blancs existent. D’autres images historiquement inexactes incluses images de diversité raciale et de genre d’« un roi britannique médiéval” et les papes.

Le PDG de Google, Sundar Pichai, a déclaré dans une note au personnel que les réponses du chatbot étaient « totalement inacceptables et que nous nous sommes trompés ».

7 / 8

Le ChatGPT d’OpenAI a donné quelques n

Un bug a provoqué le ChatGPT d’OpenAI à générer des « réponses inattendues » le mois dernier qui a eu un utilisateur interrogeant si c’était « avoir un accident vasculaire cérébral ». L’utilisateur avait interrogé ChatGPT sur les différents types d’ongles en gel, mais avait reçu une réponse se terminant par charabia en anglais et en espagnol. Un autre utilisateur a partagé ChatGPT répétant une réponse en core et encore.

Le problème a finalement été résolu, OpenAI affirmant qu’« une optimisation de l’expérience utilisateur a introduit un bug dans la manière dont le langage de traitement du modèle. “Le bug a été trouvé au moment où ChatGPT, comme d’autres grands modèles linguistiques (LLM), choisit des probabilités pour les mots suivants. dans une phrase.

8 / 8

ChatGPT d’OpenAI a lancé de fausses accusations contre des personnes

En avril 2023, Jonathan Turley, professeur de droit, a été nommé sur une liste générée par ChatGPT de juristes qui avaient été accusés de harcèlement sexuel. ChatGPT avait cité un article du Washington Post de mars 2018, affirmant que Turley avait fait des commentaires à caractère sexuel suggestif et avait tenté de toucher un homme. étudiant lors d un voyage. Mais l’article n’existait pas réellement et Turley n’avait jamais été accusé de harcèlement“C’était assez effrayant”, a déclaré Turley au Washington Post. “Une allégation de ce genre est incroyablement nuisible.”