L’IA comporte de nombreux termes. Nous avons un glossaire pour tout ce que vous devez savoir

GPU ? TPU ? LLM ? Tout le vocabulaire important de l’IA à connaître

Lorsque les personnes qui ne connaissent pas l’IA imaginent intelligence artificielle, ils peuvent imaginer le blockbuster de Will Smith Moi, Robot, le thriller de science-fiction Ex-Machina, ou le film de Disney Maison intelligente — des scénarios cauchemardesques dans lesquels des robots intelligents prennent le contrôle de leurs homologues humains, provoquant leur perte.

Les technologies d’IA générative actuelles ne sont pas encore tout à fait toutes puissantes. Bien sûr, elles peuvent être capables de semer la désinformation pour perturber les élections ou partage de secrets commerciaux. Mais la technologie en est encore à ses débuts et Les chatbots commettent encore de grosses erreurs.

Cependant, la nouveauté de la technologie fait également entrer en jeu de nouveaux termes. Qu’est-ce qu’un semi-conducteur, au fait ? En quoi l’IA générative est-elle différente de tous les autres types d’intelligence artificielle ? Et devriez-vous vraiment connaître les nuances entre un GPU, un CPU et un TPU ?

Si vous souhaitez vous tenir au courant du nouveau jargon utilisé par le secteur, Quartz vous propose un guide des termes de base.

2 / 15

Qu’est-ce que l’IA générative ?

Commençons par les bases pour un rappel. L’intelligence artificielle générative est une catégorie d’IA qui utilise des données pour créer du contenu original. En revanche, L’IA classique ne pouvait offrir que des prédictions basé sur des entrées de données, et pas de réponses nouvelles et uniques utilisant l’apprentissage machine. Mais IA générative utilisations “apprentissage profond« une forme d’apprentissage automatique qui utilise des réseaux neuronaux artificiels (logiciels) ressemblant au cerveau humain, afin que les ordinateurs puissent effectuer des analyses de type humain.

L’IA générative ne tire pas de réponses de nulle part. Elle génère des réponses en fonction des données sur lesquelles elle est entraînée, qui peuvent inclure du texte, de la vidéo, de l’audio et des lignes de code. Imaginez, par exemple, que vous vous réveillez d’un coma, les yeux bandés, et que tout ce dont vous vous souvenez, ce sont 10 articles de Wikipédia. Toutes vos conversations avec une autre personne sur ce que vous savez sont basées sur ces 10 articles de Wikipédia. C’est un peu comme ça, sauf que l’IA générative utilise des millions d’articles de ce type et bien d’autres encore.

3 / 15

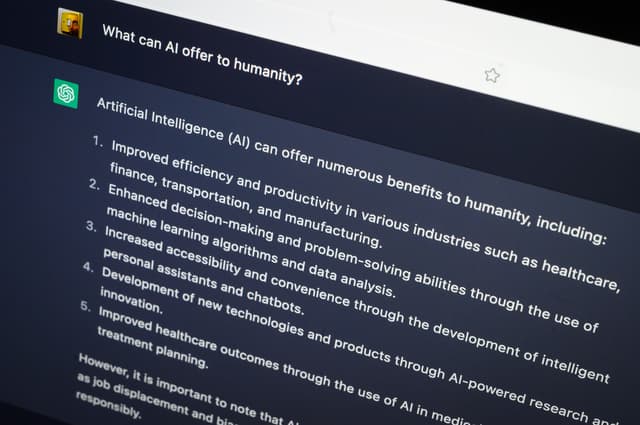

Qu’est-ce qu’un chatbot ?

Les chatbots IA sont des programmes informatiques qui générer des conversations de type humain avec les utilisateurs, en donnant des réponses uniques et originales à leurs requêtes. Les chatbots ont été popularisés par ChatGPT d’OpenAI, et depuis lors, un groupe d’autres ont fait leur apparition : Google Gemini, Microsoft CoPilot, et Einstein de Salesforce en tête, entre autres.

Les chatbots ne génèrent pas seulement des réponses textuelles — ils peuvent également créer des sites Web, des visualisations de données, aider au codage, créer des images et analyser des documents. Certes, les chatbots IA ne sont pas encore infaillibles. ils ont déjà fait beaucoup d’erreurs. Mais à mesure que la technologie de l’IA progresse rapidement, la qualité de ces chatbots augmentera également.

4 / 15

Qu’est-ce qu’un Large Language Model (LLM) ?

Les grands modèles linguistiques (LLM) sont un type d’intelligence artificielle générative. Ils sont formés sur de grandes quantités de données et de textes, notamment d’articles de presse et des livres électroniques, comprendre et générer du contenu, y compris du langage naturel texte. En gros, ils sont entraînés sur une tonne de texte afin qu’ils puissent prédire quel mot vient suivant. Prenez cette explication de Google :

« Si vous commenciez à saisir la phrase « Mary a donné un coup de pied dans un… », un modèle de langage entraîné sur suffisamment de données pourrait prédire « Mary a donné un coup de pied dans un ballon ». Sans entraînement suffisant, il pourrait ne produire qu’un « objet rond » ou uniquement sa couleur « jaune ». — L’explication de Google

Les chatbots populaires tels que ChatGPT d’OpenAI et Gemini de Google, qui ont des capacités telles que la synthèse et la traduction de texte, sont des exemples de LLM.

5 / 15

Qu’est-ce qu’un semi-conducteur ?

Non, ce n’est pas un conducteur de 18 roues. Semi-conducteurs, également connu sous le nom de puces IA, sont utilisés dans les circuits électriques d’appareils tels que les téléphones et les ordinateurs. Les appareils électroniques n’existeraient pas sans les semi-conducteurs, qui sont fabriqués à partir d’éléments purs comme le silicium ou de composés comme l’arséniure de gallium, pour conduire l’électricité. Le nom « semi » vient du fait que le matériau peut conduire plus d’électricité qu’un isolant, mais moins d’électricité qu’un conducteur pur comme le cuivre.

La plus grande fonderie de semi-conducteurs au monde, Taiwan Semiconductor Manufacturing Company (TSMC), fabrique un On estime que 90 % des puces avancées dans le monde et compte parmi ses clients les meilleurs concepteurs de puces Nvidia et Advanced MicroDevices (AMD).

Même si Les semi-conducteurs ont été inventés aux États-Unis, elle produit désormais environ 10 % des puces du monde, sans inclure les puces avancées nécessaires aux modèles d’IA plus grands. Le président Joe Biden a signé le CHIPS and Science Act en 2022 pour ramener la fabrication de puces électroniques aux États-Unis, et l’administration Biden a déjà investi des milliards dans des entreprises de semi-conducteurs notamment Intel et TSMC construire des usines dans tout le pays. Une partie de cet effort consiste également à contrer les avancées de la Chine dans la fabrication de puces et le développement de l’IA.

6 / 15

Que sont les GPU et les CPU ?

Un GPU est une unité de traitement graphique, une puce avancée (ou semi-conducteur) qui alimente les grands modèles de langage derrière les chatbots IA comme ChatGPT. C’était traditionnellement utilisé pour créer des jeux vidéo avec des visuels de meilleure qualité.

Alors informaticien ukraino-canadien, Alex Krizhevsky, a montré comment l’utilisation d’un GPU pouvait alimenter des modèles d’apprentissage en profondeur beaucoup plus rapidement qu’un processeur — une unité centrale de traitement ou le matériel principal qui alimente les ordinateurs.

Les processeurs sont le « cerveau » d’un ordinateur, exécuter des instructions pour que cet ordinateur fonctionne. Un CPU est un processeur, lequel lit et interprète les instructions du logiciel pour contrôler les fonctions de l’ordinateur. Mais un GPU est un accélérateur, un pièce de matériel conçue pour faire avancer une fonction spécifique d’un processeur.

Nvidia est le principal concepteur de GPU, avec ses puces H100 et H200 utilisées dans les centres de données des grandes entreprises technologiques pour alimenter les logiciels d’IA. D’autres entreprises cherchent à concurrencer les accélérateurs de Nvidia, notamment Intel avec son accélérateur Gaudi 3 et le GPU Azure Maia 100 de Microsoft.

7 / 15

Qu’est-ce qu’un TPU ?

TPU signifie « unité de traitement tensoriel ». Les puces de Google, contrairement à celles de Microsoft et de Nvidia, sont des TPU : des puces conçues sur mesure et spécialement conçues pour entraîner de grands modèles d’IA (alors que les GPU ont été initialement conçus pour les jeux, et non pour l’IA).

Alors que les processeurs sont des processeurs à usage général et que les GPU sont des processeurs supplémentaires qui exécutent des tâches haut de gamme, Les TPU sont des accélérateurs conçus sur mesure pour exécuter des services d’IA — les rendant d’autant plus puissants.

8 / 15

Qu’est-ce qu’une hallucination ?

Comme mentionné précédemment, les chatbots IA sont capables d’effectuer de nombreuses tâches, mais ils commettent également de nombreuses erreurs. Lorsque des LLM comme ChatGPT inventer des informations fausses ou insensées, ça s’appelle une hallucination.

Les chatbots ont des « hallucinations » lorsqu’ils ne disposent pas des données d’entraînement nécessaires pour répondre à une question, mais génèrent néanmoins une réponse qui ressemble à un fait. Les hallucinations peuvent être causées par différents facteurs tels que des données d’entraînement inexactes ou biaisées et un surapprentissage, c’est-à-dire lorsqu’un l’algorithme ne peut pas faire de prédictions ou de conclusions à partir d’autres données que celles sur lesquelles il a été formé.

Les hallucinations sont actuellement l’un des plus gros problèmes des modèles d’IA générative, et elles sont pas vraiment facile à résoudre pour. Étant donné que les modèles d’IA sont entraînés sur des ensembles de données massifs, il peut être difficile de trouver des problèmes spécifiques dans les données. Parfois, les données utilisées pour entraîner les modèles d’IA sont de toute faute, car elles vient d’endroits comme Reddit. Bien que les modèles d’IA soient formés à ne pas répondre aux questions auxquelles ils ne connaissent pas la réponse, ils ne refusent parfois pas ces questions et génèrent plutôt des réponses inexactes.

9 / 15

Qu’est-ce que la formation ?

La formation est le processus consistant à apprendre à un modèle d’IA comment faire des prédictions. Dans cette phase, un modèle d’IA est alimenté en données pour apprendre à effectuer une ou plusieurs tâches spécifiques et passe par des essais et des erreurs jusqu’à ce qu’il commence à produire les résultats souhaités.

10 / 15

Qu’est-ce que l’inférence ?

L’inférence intervient après l’entraînement et constitue le processus par lequel un modèle d’IA entraîné fait des prédictions à partir de nouvelles données. Par exemple, une voiture autonome peut être entraînée à reconnaître un panneau d’arrêt sur une route spécifique. Grâce à l’inférence, la voiture autonome serait capable de reconnaître un panneau d’arrêt sur n’importe quelle route.

11 / 15

Qu’est-ce que la génération augmentée par récupération (RAG) ?

La génération augmentée par récupération, ou RAG, est une technique de traitement du langage naturel (TAL) utilisée pour améliorer la précision des modèles d’IA génératifs. Avec RAG, les modèles de langage génératifs de grande taille sont combinés à des systèmes de recherche d’informations (comme des bases de données et des pages Web), ce qui permet aux modèles de référencer des connaissances en dehors de leurs données de formation d’origine et donc de fournir des réponses plus à jour.

Le terme a été inventé dans un Article 2020 par un groupe de chercheurs de Facebook, de l’University College de Londres et de l’Université de New York.

12 / 15

Que sont les jetons ?

Les données textuelles sont divisées en unités plus petites, appelées jetons, pour être traitées par des modèles d’IA. Les jetons peuvent aller d’une simple lettre à une phrase entière.

13 / 15

Que sont les paramètres ?

Les paramètres sont les variables qu’un modèle apprend à partir des données d’entraînement qui guident sa capacité à faire des prédictions. Au cours du processus d’entraînement, un modèle ajuste ses paramètres pour combler l’écart entre ce qu’il prédit et le résultat souhaité. Par conséquent, le modèle apprend à faire des prédictions précises sur de nouvelles données.

14 / 15

Qu’est-ce qu’un AI PC ?

Un AI PC est un ordinateur personnel qui peut gérer des tâches d’IA et d’apprentissage machine. Ils sont construits avec un CPU, un GPU et un NPU qui ont capacités spécifiques de l’IA. Une NPU, ou unité de traitement neuronal, est une puce spécialisée dans l’exécution de tâches basées sur l’IA et l’apprentissage machine sur l’ordinateur sans avoir à envoyer ces données à traiter dans le cloud.

15 / 15

Qu’est-ce qu’une unité de traitement neuronal (NPU) ?

Une unité de traitement neuronal (NPU) peut exécuter des tâches d’intelligence artificielle et d’apprentissage automatique directement sur un appareil, tel qu’un PC AI, ce qui signifie que les données n’ont pas besoin d’être envoyées vers le cloud pour être traitées.